Поисковые системы и парсинг

Возможно, многие зададутся вопросами, связанными с оптимизацией - а каково влияние размещаемых парсером публикаций на позиции сайта в поисковой выдаче? Как поисковые системы будут воспринимать сайт, публикующий материалы из других источников? Будут ли индексироваться опубликованные материлы? и т.д. и т.п. Данная глава руководства призвана ответить на все подобные вопросы.

Миф первый - поисковики наказывают сайты за неуникальный контент

Давайте посмотрим на новостные лента самих поисковых систем - Яндекса, Гугла. Или заглянем в колонки новостей того же Рамблера. Что мы там увидим? Совершенно верно - подборку новостей с различных интернет-ресурсов. И если поисковые системы вольны публиковать в новостных лентах все, что им вздумается и при этом хорошо ранжировать в выдаче подобные страницы, то тот же всеми известный Рамблер никак не обижен поисковиками, хоть и не имеет к ним никакого отношения. Несмотря на практически нулевую уникальность контента он занимает достойные места в поисковой выдаче. И уж тем более речь не идет о каких-либо санкциях со стороны поисковых систем. Можно привести десятки подобных примеров, что никак не повлияет на суть - главное в контенте это не уникальность, а его полезность для пользователей.

Миф второй - поисковые системы плохо индексируют неуникальный контент

Специально, чтобы опровергнуть данное утверждение было куплено несколько новых доменов, на каждый из которых установлена InstantCMS 2 и компонент "Парсер контента". При этом сайты были абсолютно "чистые", без единой публикации. Не предпринималось никаких мер, чтобы добавить сайты в индекс(аддурилку) Яндекса и Гугла, просто установили систему и запустили парсер. Для наполнения сайтов с различных источников было настроено, в общей сложности, 37 заданий и включена публикация по CRON-у.

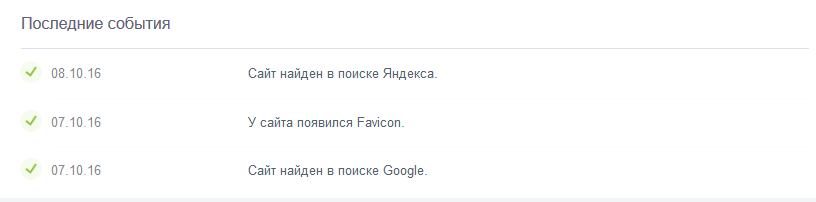

Примерно через неделю начали появляться первые результаты индексирования сайтов поисковыми системами

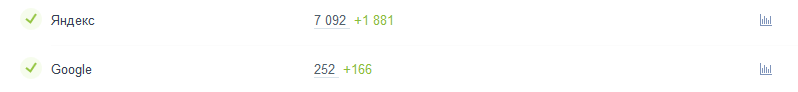

а в течении 11 дней все без исключения сайты попали в индекс. После попадания первых страниц в индекс поисковых систем мы дали поисковикам ровно 10 дней на их индексацию. По прошествии этого срока провели небольшой мониторинг и на всех сайтах наблюдалась примерно такая картина:

Как вы сами видите, не каждый сайт может похвастаться такой историей индексации контента. А ну-ка, попробуйте за 2 недели разместить на свежекупленном домене свыше 1000 публикаций и загнать их в индекс. Возможно у вас это и получится, однако сколько вам придется потратить на это сил и средств ... Ну а еще через неделю:

Проведенное исследование окончательно развеяло все опасения по поводу проблем с индексацией сайтов, наполняемых с помощью компонента "Парсер контента". Все сайты в кратчайшие сроки попали в индекс поисковых систем и не было обнаружено никаких проблем с индексированием.

Миф третий - сайт с неуникальным контентом не займет достойного места в выдаче

Сама по себе идея "уникальности контента" долгое время была одним из китов, на которых держались поисковые системы. Таким же, как и ссылки, от которых они и сейчас не в состоянии отказаться. Однако гонка за уникальностью и переписывание статей с одного сайта на другой(рерайт) со 100% уникальностью уже давно заставили поисковые системы перестать ранжировать уникальные тексты выше и сделать ставку на полезность контента для пользователей. Если публикация удовлетворяет все запросы пользователя, то поисковой системе абсолютно безразлично насколько уникально ее содержимое. И уж абсолютно точно, что даже самый отличный рерайт ничем по своей сути не отличается от откровеннейшего копипаста. Правда бывают случаи, когда рерайт оказывается намного хуже.

А как быть с тем, что точно такая же статья есть на том сайте, откуда она была получена парсером? - спросите вы. Ведь по идее сайт-источник должен ранжироваться лучше ... В этих словах есть доля правды, но, к сожалению она настолько мала, что ею можно пренебречь. Во-первых, поисковые системы до сих пор так и не научились достоверно определять авторство, а во вторых, даже если авторство текста им известно, зачастую они отдают предпочтение не сайту-источнику, а другим сайтам, разместившим копию публикации с сайта источника. И причин тут может быть великое множество:

- Дизайн и юзабилити сайта (Возможно сайт-источник и заслуживает внимания как ресурс, генерирующий контент, но с вероятностью более 80% этот момент будет проигнорирован поисковыми системами, если точно такой же контент будет размещен на сайтах, более удобных для пользователей с точки зрения поисковых систем, чем сайт-источник. Поисковик покажет пользователю страницу, которая по его мнению обладает большим уровнем удобства для пользователя проигнорировав при этом сайт-источник.)

- Скорость загрузки страницы (Не для кого не секрет, что поисковые системы придают огромное значение времени загрузки страниц сайта. И если ваш сайт работает быстрее и стабильнее сайта-источника, то и занять первые места в выдаче у вас больше шансов.)

- Авторитетность сайта / Соответствие тематике (с большой долей вероятности, сайт, содержащий копию оригинального текста с сайта-источника займет более высокие позиции в выдаче, чем сам сайт-источник, если он обладает более высокими показателями доверия(тИЦ, PR, траст и т.д.) или больше соответствует тематике поискового запроса.)

- Социальная активность (Если аудитория вашего сайта проявляет более высокую социальную активность, чем аудитория сайта-источника, то несомненно ваш сайт будет занимать более высокие позиции в выдаче, чем сайт источник. Да, лайки, твиты и прочие социальные проявления играют порой большую роль, чем содержание страницы.)

Это лишь несколько основных аспектов, демонстрирующих, насколько низка роль уникальности контента в наше время. Сама по себе уникальность может являться только гарантией того, что страница с уникальным контентом будет проиндексирована поисковыми системами, но не дает никаких преимуществ. Именно поэтому продвижение ссылками предполагает написание уникальных текстов, ведь непроиндексированная ссылка это деньги на ветер. Но если вы думаете об аудитории и посещаемости своего сайта, то уникальность в этом деле слабый помощник.

Как вы могли заметить, все вышеперечисленные пункты говорят то же самое, что и Яндекс.Вебмастер - "Продолжайте развивать Ваш сайт для пользователей ...". Сделайте сайт быстрее, удобнее, привлекательнее для пользователей, ведь теперь у вас будет для этого много времени, сил и средств. А проблему наполнения контентом можете смело доверить парсеру.

Комментарии